这一篇笔记不太好做,由于机器学习的研究者来自不同背景,有着不同的语言习惯,所以很多时候同一个概念在不同文献中有很多不同的名字,我这里也只是基于我目前了解到的内容进行简单的整理,如有纰漏,欢迎友好交流。

基本概念与术语

首先是一些通用的概念术语:

样本(sample)/实例(instance):我们获得的数据集中的一条数据,被称为一个样本/实例,在不存在数据缺失的情况下,所有样本应该具有相同的结构。样本是一个统计学概念,很多时候,一个样本对应一个个体,或者对某个对象的一次观测(observation);特征(feature)/属性(attribute):记录样本的某种性质或者在某方面的表现的指标或变量,有时候我们直接用原始数据的变量作为特征,而有的时候我们对原始变量施加一个映射,转变为一组新的变量作为特征,这个过程也被称为特征提取(feature extraction),可以用来提取信息或者对数据进行降维;例如,原始变量是身高和体重,我们利用公式计算出BMI作为我们关心的特征,就把两个变量减少为了一个,降低了变量的维数;特征向量(feature vector):一个样本的全部特征构成的向量,称为特征向量。即使经过了特征提取,我们往往也会用提取得到的特征构成新的目标数据集,得到新的样本变量(毕竟特征才是我们关注的变量)。还是以身高体重为例,我们获得了小明的身高、体重,构成了一个样本;但我们关注的是BMI指数,于是我们计算出小明的BMI,这时小明的BMI就成了新的样本。我们关注的永远是特征构成的样本,因此,我们可以说,一个特征向量就是一个样本;特征空间(feature space)/属性空间(attribute space)/样本空间(sample space): 由所有特征/属性张成的空间,也即特征向量所在的空间,每一维对应一个特征(其实就是概率论中样本空间的一种具体形式,只不过后者强调随机事件);学习(learning)/训练(training):模型凭借数据提供的信息改进自身性能的过程;测试(testing):训练结束之后检验模型训练效果的过程;训练数据(training data)/训练集(training set):训练模型使用的数据集,其中的每一个样本称为一个训练样本(training sample);测试数据(testing data)/测试集(testing set):测试模型使用的数据集,其中的每一个样本称为一个测试样本(testing sample);泛化能力(generalization ability):在测试集上训练得到的模型,适用于训练集之外的样本的能力,或者说训练好的模型在整个样本空间上的表现。测试的目的之一也是检验模型的泛化能力;过拟合(overfitting):模型过度学习,导致学习了过多只属于训练数据的特点,反而使得泛化能力下降;欠拟合(underfitting):模型学习不足,导致没有学习到训练数据中足够的一般化规律,泛化能力不足;机器学习三要素

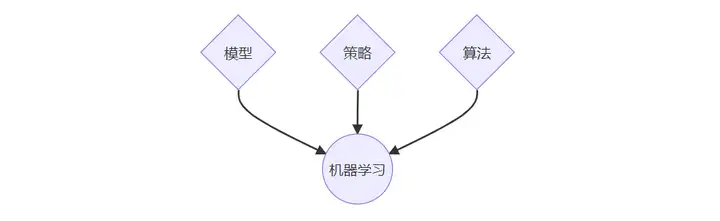

机器学习有三大要素:模型、策略(学习准则)、算法。

模型

模型是机器学习方法的核心,也是学习过程的最终结果。围绕模型,有如下的基本概念:

假设空间(hypothesis space):机器学习的目的是学习一个模型,我们把所有可能的模型构成的集合称为假设空间,所以,我们进行机器学习的目的,是利用训练集从假设空间中得到一个最优的模型;版本空间(version space):由于训练集是有限集合,我们有可能得到不止一个最优模型,我们把训练集上得到的所有最优模型构成的集合称为版本空间(version space),它是假设空间的一个子集;归纳偏好(inductive bias):当版本空间中存在不止一个最优模型时,我们如何给出最终的模型?为了缩小我们的选择范围,往往需要在学习前对模型添加一些约束或者假设,这些约束或假设就称为归纳偏好。归纳偏好的选择需要结合具体问题,不能一概而论;正如“没有免费的午餐”定理(No Free Lunch Theorem)指出的:如果同时同等考虑所有问题,则所有模型的平均表现相同。一个很常见的基本归纳偏好是奥卡姆剃刀原理(Occam’s razor):如无必要,勿增实体,在机器学习里,这意味着应当选择同等效果下最简单的模型。策略/学习准则

策略是从假设空间里学习最优模型的准则,离开了策略,“最优”就无从谈起了。该使用什么样的策略,并没有严格规定,只是一种选择,但还是有一些常用的策略,如监督学习中的经验风险最小化(empirical risk minimization)、结构风险最小化(structural risk minimization)等。

算法

机器学习的算法是基于训练集,在假设空间上根据策略优化模型的具体计算方法,基本上属于优化问题,可以使用一些已有的最优化算法,有时也需要结合模型设计新算法。

按主流划分方式,机器学习可以分为监督学习、无监督学习、半监督学习、强化学习、主动学习等。下面对其中最常用、形式相对最清晰的监督学习中的一些基本概念进行介绍。监督学习的基本概念和通用术语

什么是监督学习?

按上面所述,我们获得的数据集都是由一个一个的样本(特征向量)堆叠而成的,而有些时候在这些特征之外,我们还能获得样本对应的某个/某些指标,这个/这些样本指标与样本特征之间存在某种联系,我们希望模型能够学习这种联系,使得在给定一组具体的样本特征后,模型基本可以确定对应的具体指标,这个过程就是监督学习,所谓监督指的是根据已经标注的样本目标指标来优化模型,就好像这些指标在监督算法的学习过程。这个/这些目标指标变量称为响应变量(response)/因变量(dependent variable)/被解释变量,而用于确定响应变量的特征则称为预测变量(predictor)/自变量(independent variable)/解释变量(实质上也就是回归分析中的被解释变量和解释变量)。用如下的数学语言解释起来可能更直观:

假设我们有 pp 个变量 X1,…,XpX_1,\dots,X_p,另外有一个变量 YY,假设 YY 与 X1,…,XpX_1,\dots,X_p 之间存在某种关系,可以表示为 Y=f(X)+εY=f(X)+\varepsilon,其中 X=(X1,…,Xp)X=(X_1,\dots,X_p),ff 表示一个未知的 pp 元函数,ε\varepsilon 是一个随机变量,表示某种不可测的误差或干扰(通常情况下问题中都含有某些误差),那么监督学习就是在给定某些假设条件的前提下,估计 ff 的过程。YY 和 XX 分别为响应变量和预测变量,ε\varepsilon 称为随机误差(random error)/随机扰动(random disturbance)/噪声(noise)。

这种表述实质上也是回归分析的数学形式表述,但区别在于:监督学习往往以预测为目的,只要能得到给定 XX 时 f(X)f(X) 的预测值,ff 的形式不是必须得出的;而回归分析除了预测往往还需要进行统计推断,关心预测变量和响应变量之间的具体关系,因此通常要求得出具体的 ff。

监督学习的两类任务

首先简单介绍一下变量类型。我们在数据中遇到的变量可以分为两大类:

取值为连续数值的变量,称为定量变量(quantitative variable),例如身高、体重、年龄、温度、GDP、人口(连续整数)……由此构成的数据称为定量数据;

取值不是数值(且通常至多取有限个离散值)的变量,称为定性变量(qualitative variable)/分类变量(categorical variable)/离散变量(discrete variable),例如性别、年级、学历、政治面貌、婚姻状况、季节、职业……由此构成的数据称为定性数据/分类数据;

需要指出的是,定性变量和定量变量不是一成不变的,在某些情况下它们可以互相转化,例如,月份是1-12的整数,它可以是一个定量变量,但由于它只能取有限个离散的值,因此完全可以将其视为定性变量;性别本身是定性变量,但如果用0和1分别表示男和女,形式上它又是定量的了。在监督学习中,按响应变量的类型划分,有两大类任务:

响应变量是定量变量时,我们称监督学习的任务为回归(regression)

响应变量是定性变量时,我们称监督学习的任务为分类(classification)

实质上这只是机器学习里的一种习惯性命名方式,在统计学的回归分析中,既要研究定量响应变量也要研究定性响应变量(如逻辑回归),当然,由于输出的数据类型不同,两类方法之间存在较大差异,机器学习中按此分类是合理的。

此外,如果响应变量不止一个,对于回归问题而言推广为多重多元回归(multivariate multiple regression)(统计学问题),对于分类问题而言则推广为标注(tagging)问题。监督学习的基本术语

输入空间(input space):模型的输入的全体可能取值构成的集合;

输出空间(output space):模型输出结果的全体可能取值构成的集合;

特征空间(feature space):与前文定义相同,需要注意的是对于监督学习,输入空间和特征空间可能相同也可能不同,这完全取决于是否进行了特征提取,以及特征提取是在模型之外完成的还是包含在模型中。需要记住的是,学习永远是在特征空间上进行的;

损失函数(loss function)/代价函数(cost function):监督学习的目标是对于预测变量给定的输入值 XX,根据模型输出响应变量的预测值 f(X)f(X)(这与前面的记号是一致的,因为随机误差是不可预测的,能预测的部分只有 ff ),这个预测值与响应变量的真实值 YY 可能存在偏差,为了进行优化,需要先用一个函数度量一下偏差程度,这个函数就称为损失函数或代价函数,它是 f(X)f(X) 和 YY 的非负实值函数,通常记为 L(Y,f(X))L(Y,f(X))。

常用的损失函数有0-1损失函数、平方损失函数、绝对损失函数、对数(似然)损失函数、交叉熵损失函数、Hindge损失函数等等; 风险函数(risk function)/期望损失(expected loss):监督学习中,通常假设预测变量 XX 与响应变量 YY 服从联合概率分布 P(X,Y)P(X,Y),此时损失函数 L(Y,f(X))L(Y,f(X)) 就是一个随机变量,其期望 EP[L(Y,f(X))]=∫X×YL(y,f(x))P(x,y)dxdy\mathrm{E}_P[L(Y,f(X))] = \displaystyle\int_{\mathcal{X\times Y}}L(y,f(x))P(x,y)\mathop{}\!\mathrm{d}x\mathrm{d}y 就称为风险函数或期望损失,记作 Rexp(f)R_\mathrm{exp}(f);上述风险函数的定义是基于 XX 与 YY 的总体联合概率分布 P(X,Y)P(X,Y) 的,但问题在于,这个分布我们无法获得,否则我们就直接可以得到条件概率分布 P(Y|X)P(Y|X),也就可以直接预测 YY,不需要训练模型了,那么应该怎么办呢?统计学告诉我们,在总体分布不清楚的时候,可以用样本来推断总体,于是就有了下一个概念: 经验风险(empirical risk)/经验损失(empirical loss):在样本(训练集)上损失函数的平均值,记作 Remp(f)R_\mathrm{emp}(f),实质上也就是样本形式的风险函数,如果记训练集为 T={(x1,y1),…,(xN,yN)}T = \{(x_1,y_1),\dots,(x_N,y_N)\},则 Remp(f)=1N∑i=1NL(yi,f(xi))R_\mathrm{emp}(f) = \dfrac 1 N \sum\limits_{i=1}^N L(y_i,f(x_i));有了这些概念,就可以介绍监督学习的基本策略了。

监督学习中常用的基本策略

监督学习中有两大类常用的策略:经验风险最小化(empirical risk minimization, ERM)和结构风险最小化(structural risk minimization, SRM)。

经验风险最小化(ERM):在假设空间的所有映射中,选择使得经验风险最小的模型,用数学语言表示为 minf∈FRemp(f)\min\limits_{f \in \mathcal F}R_{\mathrm{emp}}(f),其中 F\mathcal F 为假设空间;统计学中的很多方法都可以看作是经验风险最小化的方法,如最小二乘回归,可以看作是线性假设空间中,采取平方损失函数的经验风险最小化方法;而重要的最大似然估计,也可以看作是采取对数损失函数的经验风险最小化方法。 结构风险最小化(SRM):当样本量不够大时,使用经验风险最小化可能会导致过拟合,这时就需要对经验风险最小化准则进行修正,一种策略是所谓的正则化(regularization)方法,即增加一个正则项(regularizer)或惩罚项(penalty item),用来衡量某个我们希望控制在较低水平的值(通常为模型复杂度),加上惩罚项的经验风险就称为结构风险(structural risk),记作 Rsrm(f)R_\mathrm{srm}(f),用数学语言表示为 Rsrm(f)=Remp(f)+λJ(f)R_\mathrm{srm}(f) = R_\mathrm{emp}(f) + \lambda J(f),其中 J(f)J(f) 是假设空间上的一个泛函(可以理解为函数的函数),参数 λ⩾0\lambda \geqslant 0 用来调整经验风险和惩罚项的比重。在假设空间中,选择使得结构风险最小的模型,这种策略就称为结构风险最小化准则,用数学语言表示为 minf∈FRsrm(f)\min\limits_{f \in \mathcal F}R_{\mathrm{srm}}(f),其中 F\mathcal F 为假设空间;统计学中使用结构风险最小化准则的方法也有很多,如使用参数向量的1-范数作为惩罚项的LASSO回归,使用参数向量的2-范数作为惩罚项的岭回归等等。如果本文对你有帮助,请记得点赞收藏,下次见 ~ ❤️